Sophia, Hanson Robotics Ltd, Hong Kong 2016 ©Wanda Tuerlinckx.

Sophia, Hanson Robotics Ltd, Hong Kong 2016 ©Wanda Tuerlinckx.

«Il gioco [dell’imitazione] può forse essere criticato sulla base del fatto che le possibilità sono troppo nettamente a sfavore della macchina. Se l’uomo dovesse cercare di fingere di essere una macchina, farebbe certamente una pessima figura. Sarebbe tradito immediatamente dalla sua lentezza e imprecisione nell’aritmetica. Non possono forse le macchine comportarsi in qualche maniera che dovrebbe essere descritta come pensiero, ma che è molto differente da quanto fa un uomo?».

(A. M. Turing, 1950)

In Blade Runner Rick Deckard sottopone i suoi interrogati al test di Voight-Kampff, così da poter discriminare tra umani e replicanti: i secondi pressoché identici ai primi e tuttavia incapaci di provare emozioni analoghe a quelle dell’uomo.11Adattamento cinematografico del romanzo Do Androids Dream of Electric Sheep di Philip K. Dick (1968), il cui titolo è stato inizialmente tradotto in italiano come Il Cacciatore di Androidi. In un secondo momento è stata proposta la traduzione Ma gli androidi sognano pecore elettriche?, da cui l’autore trae ispirazione per il titolo di questo articolo.

Il test di Voight-Kampff, per analogia di scopo,22E cioè discriminare tra intelligenza umana e artificiale.

è simile al test di Turing, introdotto dallo stesso Alan Turing nel suo pioneristico saggio sull’intelligenza macchinica33Preferisco giustappore l’aggettivo ‘macchinico’ anziché ‘artificiale’ al termine ‘intelligenza’ quando si discute del tipo di intelligenza specifica di macchine e dispositivi tecnologici. In un certo senso, l’intelligenza umana non è meno artificiale di quella delle macchine, considerando che essa tende ad aumentare continuamente il proprio spettro cognitivo e sensoriale per mezzo di supporti tecnologici (Cf. Pasquinelli, 2015).

del 1950 che, in maniera provocatoria, si apre con la domanda: le macchine sono in grado di pensare?44Nel testo originale: «Can machine think?» (Turing, 1950, 1).

Turing suggerisce di riformulare questo dilemma sotto forma di un test comportamentale, detto ‘gioco dell’imitazione’, a cui partecipano tre soggetti, due umani e un computer. Il gioco, in breve: un esaminatore umano sottopone una serie di domande scritte a un altro essere umano e a un computer, entrambi separati fisicamente dal primo di modo che questi non possa sapere da chi provengano le risposte. Un computer supera il test di Turing – e gli viene dunque riconosciuta la capacità di simulare un comportamento intelligente – se l’interrogatore si dimostra incapace di stabilire con certezza chi sia di volta in volta a rispondere alle sue domande.

OK-RM, graphics for ‘Fear and Love’, exhibition at Design Museum, London 2016.

OK-RM, graphics for ‘Fear and Love’, exhibition at Design Museum, London 2016.

Il motif del test, e dunque dell’esaminazione delle Intelligenze Artificiali in funzione della loro capacità di simulare ragionamenti e comportamenti analoghi a quelli dell’uomo, è stato riproposto nel film Ex Machina. In particolare, nel film è valutata la capacità di un robot umanoide di dimostrarsi intelligente (ossia capace di ragionamenti complessi), autocosciente (ossia consapevole della propria natura macchinica e del proprio funzionamento), e in grado di provare e suscitare reazioni empatiche.55Film del 2015 scritto e diretto da Alex Garland.

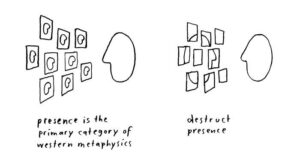

In Ex Machina si ricorre al test di Turing ‘totale’ che, rispetto alla sua concezione originaria, prevede l’interazione verbale e il contatto visivo diretto – seppur mediato da una parete di vetro – tra esaminatore e soggetto esaminato. In realtà, diversamente da quanto previsto dal test di Turing, in Ex Machina l’esaminatore sa già di star dialogando con un robot: a essere messa in discussione non è tanto l’intelligenza dell’androide, comunque sia essa intesa, quanto la prontezza dell’uomo nel riconoscere e accettare, da un lato, l’umanizzazione, e dunque il divenire persona dell’androide, e, dall’altro, la macchinizzazione, e dunque il carattere inumano di quelle che tradizionalmente erano considerate prerogative esclusive e distintive dell’uomo (moderno): il pensiero razionale e la coscienza di sé.

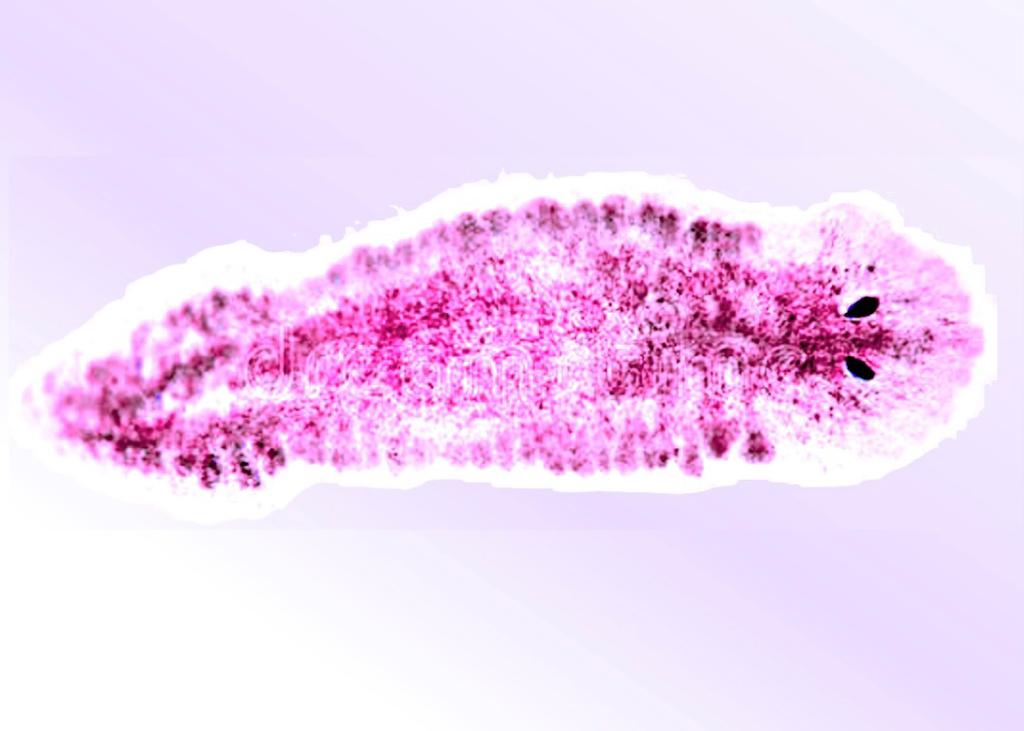

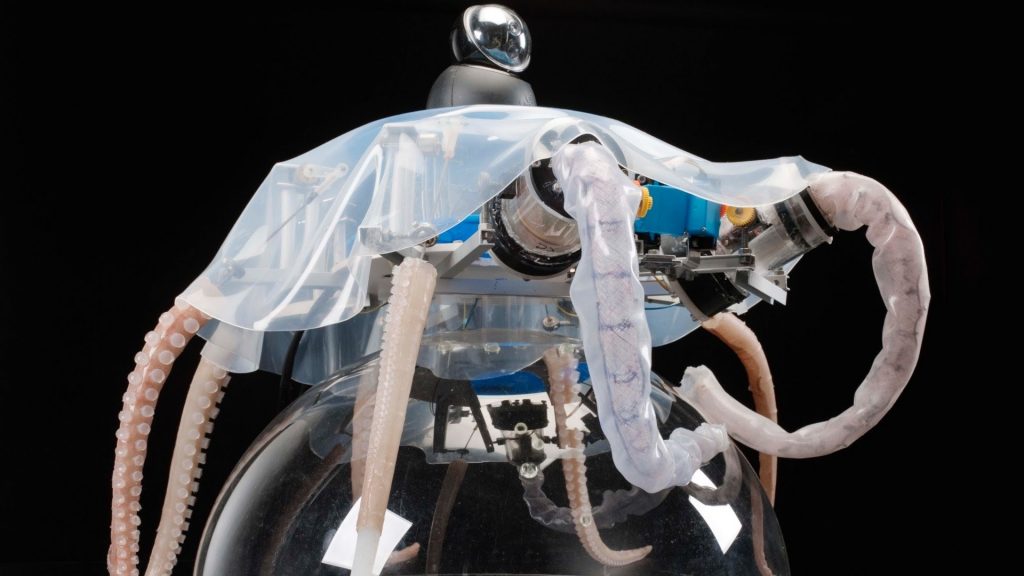

Hiroshi Ishiguro e Geminoid HI-4, Hiroshi Ishiguro Laboratories (ATR), 2013.

Hiroshi Ishiguro e Geminoid HI-4, Hiroshi Ishiguro Laboratories (ATR), 2013.

Oskar Shclemmer, costumi e coreografie per il Balletto Triadico.

Oskar Shclemmer, costumi e coreografie per il Balletto Triadico.

Sia il test di Voight-Kampff sia il test di Turing66In tutte le sue varianti.

sono esemplificativi di una doppia e consolidata tendenza, tanto nella tradizione popolare/fantascientifica quanto in quella accademica, a definire e misurare l’Intelligenza Artificiale in termini comparativi rispetto a quella umana e, più in generale, ad antropomorfizzare sistemi cognitivi non-umani. A partire dagli anni Cinquanta, i primi studi sulle Intelligenze Artificiali hanno assunto come premessa che «ciascun aspetto dell’apprendimento e qualsiasi altra componente dell’intelligenza [umana] possono essere così precisamente descritti da consentire la costruzione di una macchina in grado di simularli».77Cf. McCarthy et al. (1950, mia traduzione dall’inglese).

In altre parole, ciò voleva dire che, una volta definita un’esaustiva teoria della mente, sarebbe stato possibile codificare e tradurre i processi mentali in modelli logico-computazionali.

Quest’assunzione, che è alla base del concetto di Intelligenza Artificiale debole, costituisce a sua volta la premessa per la cosiddetta Intelligenza Artificiale forte, ossia: le macchine che sono in grado di emulare l’intelligenza umana sono effettivamente in grado di pensare e non si limitano dunque a simulare un comportamento intelligente analogo a quello dell’uomo.88Cf. Russell e Norvig (2009).

In realtà, la possibilità di progettare un’Intelligenza Artificiale, sia essa debole o forte, dipende, ancor prima che da questioni tecnico-scientifiche o filosofiche, da riflessioni prettamente terminologiche. Russell e Norvig (2009, 1020) definiscono Intelligenza Artificiale:«la ricerca del miglior programma agente per una specifica architettura. […] Per ciascun’architettura digitale con k bit di memoria ci sono esattamente 2k programmi agenti, e per trovare quello migliore bisogna semplicemente enumerarli e testarli tutti».99Mia traduzione dall’inglese. Secondo Russell e Norvig (2009) un agente artificiale intelligente si compone di due elementi principali: un’architettura e un programma. La prima è costituita da un supporto tecnologico provvisto di sensori (per ricevere input ambientali) e attuatori (per agire sul proprio ambiente). Il secondo è una funzione logico-matematica che consente di convertire, in ciascun momento, gli input ambientali in determinate azioni.

Espressa in questi termini – e prescindendo teoricamente dalle difficoltà di calcolo per k molto grandi – l’Intelligenza Artificiale è per definizione possibile. Ciononostante, approcci e, specularmente, obiezioni all’Intelligenza Artificiale continuano a cadere nel doppio errore antropocentrico di antropomorfizzare l’intelligenza delle macchine e di pretendere che queste ultime emulino o posseggano qualità biomorfiche per essere considerate intelligenti.1010Cf. Bratton (2015).

Givenchy by Alexander McQueen, Fall Winter 1999.

Givenchy by Alexander McQueen, Fall Winter 1999.

In realtà, lo schema comparativo e antropo-riflessivo che aveva inizialmente contraddistinto le ricerche sull’Intelligenza Artificiale è stato gradualmente abbandonato a favore di un approccio razionalista. Come ironicamente suggerito dall’informatico Edsger Dijkstra (1984),1111Citato in Russell e Norvig (2009, 1021, mia traduzione dall’inglese).

al fine di progettare macchine intelligenti, «chiedersi se [esse] siano in grado di pensare… è rilevante tanto quanto chiedersi se i sottomarini siano capaci di nuotare». In altre parole, ciò vuol dire che il compito degli scienziati non è progettare macchine che simulino il pensiero o il comportamento umano, ma sviluppare sistemi cognitivi sintetici capaci di agire razionalmente e in grado quindi di trovare soluzioni desiderabili/ottimali al problema che sono chiamati a risolvere. Inoltre, viene in questo modo rimarcato come la possibilità di costruire macchine intelligenti dipenda da cosa s’intende per ‘intelligenza’ e dai termini in cui viene posta questione: «La prima definizione di nuotare proposta dall’American Heritage Dictionary è ‘muoversi attraverso l’acqua per mezzo di arti, pinne o code’ e la maggior parte delle persone concorda sul fatto che i sottomarini, essendo sprovvisti di arti o pinne, non siano capaci di nuotare. Il dizionario inoltre definisce volare come ‘muoversi attraverso l’aria per mezzo di ali o parti simili ad ali’ e la maggior parte delle persone concorda sul fatto che gli aeroplani, avendo delle componenti simili ad ali, siano in grado di volare. Tuttavia queste domande, così come le relative risposte, non hanno alcuna rilevanza nella costruzione di aeroplani e sottomarini; si tratta invece di questioni che riguardano l’uso delle parole nella lingua inglese».1212Cf. Russell e Norvig (2009, 1021, mia traduzione dall’inglese).

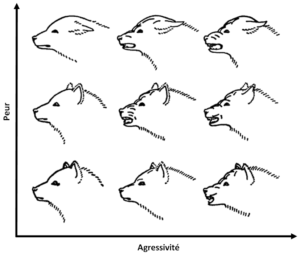

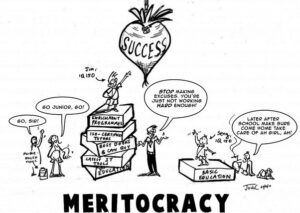

Un primo fondamentale passo verso una migliore comprensione dell’intelligenza macchinica consisterebbe dunque nel riconoscere che essa può esistere e realizzarsi in forme/scale non necessariamente biomorfiche e funzionare diversamente rispetto a quella umana, che rappresenta soltanto una particolare tipologia di intelligenza. Oggigiorno, tuttavia, il doppio pregiudizio antropocentrico di antropomorfizzazione e comparazione riflessiva che contraddistingue lo studio, lo sviluppo e la critica delle Intelligenze Artificiali persiste negli attuali dibattiti su intelligenza macchinica e robotica avanzata che, in maniera polarizzata, tendono a reiterare utopiche fantasie di miglioramento o distopiche ansie di distruzione della vita dell’uomo per mano di robot umanoidi. In altre parole, l’immaginario ereditato dalla tradizione fantascientifica ha radicato, nella cultura popolare, una confusione sostanziale tra Intelligenza Artificiale e robotica biomimetica, con la prima che viene molto spesso ‘riconosciuta’ solo quando inscrivibile, in senso estetico e funzionale, in forme/scale biomorfiche. È questo il caso dei robot umanoidi, su cui si tende a proiettare riflessivamente qualità umane, riducendo così la complessità del rapporto co-evolutivo tra intelligenza umana e macchinica a questioni di solidarietà (empatia) / rivalità (circospezione). Per fornire qualche esempio, approcci critici all’economia politica del tecno-capitalismo cognitivo molto spesso speculano sulla plausibilità di uno scenario futuro in cui l’automazione del lavoro è portata a compimento per mezzo di robot che sempre più tentano di ‘rubarci’ il lavoro.1313Cf. F. Pistono, Robots Will Steal Your Job, But That’s OK: How to Survive the Economic Collapse and Be Happy, CreateSpace, 2014.

Lo sviluppo di interfacce avanzate per l’interazione uomo-macchina è spesso grottescamente discusso nei termini della presunta devianza psicologica da cui sono affette le persone che sviluppano relazioni morbose con artefatti tecnologici, o sollevando questioni etiche legate alla vendita di bambole robotiche a scala umana progettate per soddisfare le più audaci fantasie sessuali delle persone (tendenzialmente ricche e di sesso maschile).1414Si veda per esempio il documentario del Guardian sui robot del sesso.

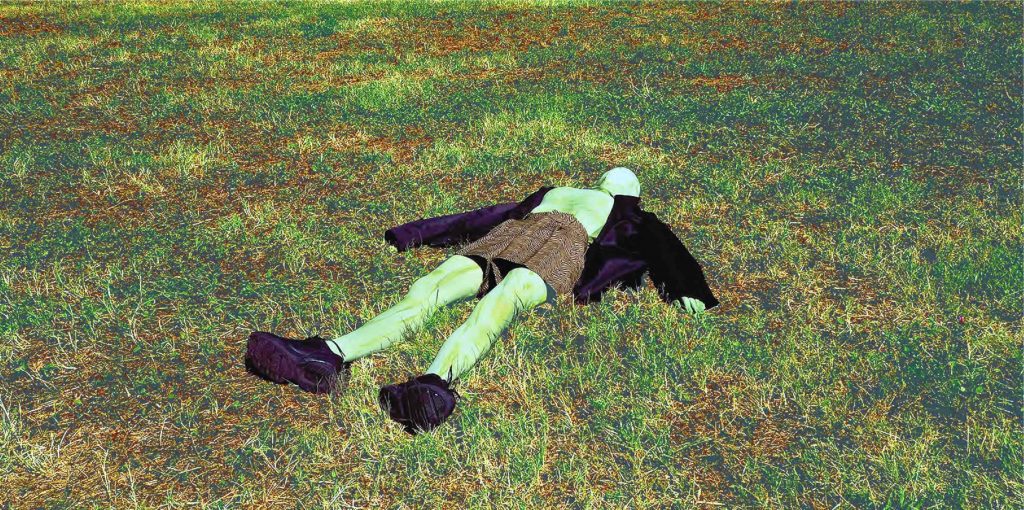

Sergio Sarri, Studio per “L’Inumano”, 1991.

Sergio Sarri, Studio per “L’Inumano”, 1991.

Di recente, vari dibattiti sull’Intelligenza Artificiale hanno toccato temi chiave della sfera politica e normativa come quello dei ‘diritti’, della ‘cittadinanza’ e del concetto stesso di ‘democrazia’. Nell’ottobre 2017, per esempio, la stampa internazionale ha riportato con molta enfasi la notizia che in Arabia Saudita fosse stata riconosciuta la piena cittadinanza a un androide di nome Sophia, capace di emulare espressioni facciali e di sostenere conversazioni interattive. Nel novembre 2017, in Nuova Zelanda, è stato presentato al pubblico il progetto politico di Sam, un chatbot dotato di un sistema di apprendimento che interagisce in tempo reale con potenziali elettori – tramite la chat di Facebook Messenger – allo scopo di raccogliere dati sulle loro opinioni e poter così definire un esaustivo programma elettorale.1515Per quanto riguarda il controverso rapporto tra androidi e strumenti di democrazia diretta, si segnala la serie manga Demokratia di Motoro Mase (ringrazio l’amico Iago Menichetti per il suggerimento).

A Sam (e dunque al suo ideatore) potrebbe forse essere riconosciuto il diritto di candidarsi come primo ministro alle elezioni generali del 2020.

A dire il vero, simili proclami somigliano più a strategiche campagne di marketing che a credibili programmi politici o ad approcci seri all’aspetto ‘politico’ e socio-trasformativo dell’intelligenza macchinica e del pensiero automatizzato. Cercando dunque di superare la nozione classica e la concezione fantascientifica di Intelligenza Artificiale, che cosa s’intende davvero quando si parla di intelligenza macchinica e automazione cognitiva? Benché non sia facile dare una risposta esaustiva a questa domanda, oggigiorno i più avanzati sistemi di Intelligenza Artificiale possono essere ricondotti all’applicazione di metodi algoritmici di induzione statistica utilizzati per il riconoscimento di pattern e correlazioni tra dati omogenei o eterogenei. Il sintagma ‘Intelligenza Artificiale’, dunque, si riferisce più propriamente ad agenti algoritmici, i più avanzati dei quali sono dotati di autonomia cognitiva e capacità di apprendimento. Per ‘apprendimento’ s’intende la capacità dell’algoritmo di migliorare nel tempo la propria efficacia performativa. Ciò vuol dire in pratica che l’algoritmo, all’aumentare delle informazioni processate, impara a svolgere in maniera sempre più efficace il compito per cui è stato inizialmente programmato. L’autonomia cognitiva si riferisce alla misura in cui l’agente algoritmico, nel ciclico processo di traduzione input/output e verifica di questi ultimi, riesce via via a ‘trascendere’ la conoscenza del mondo impartita dall’uomo e a interiorizzare strategie metacognitive (impara a imparare).

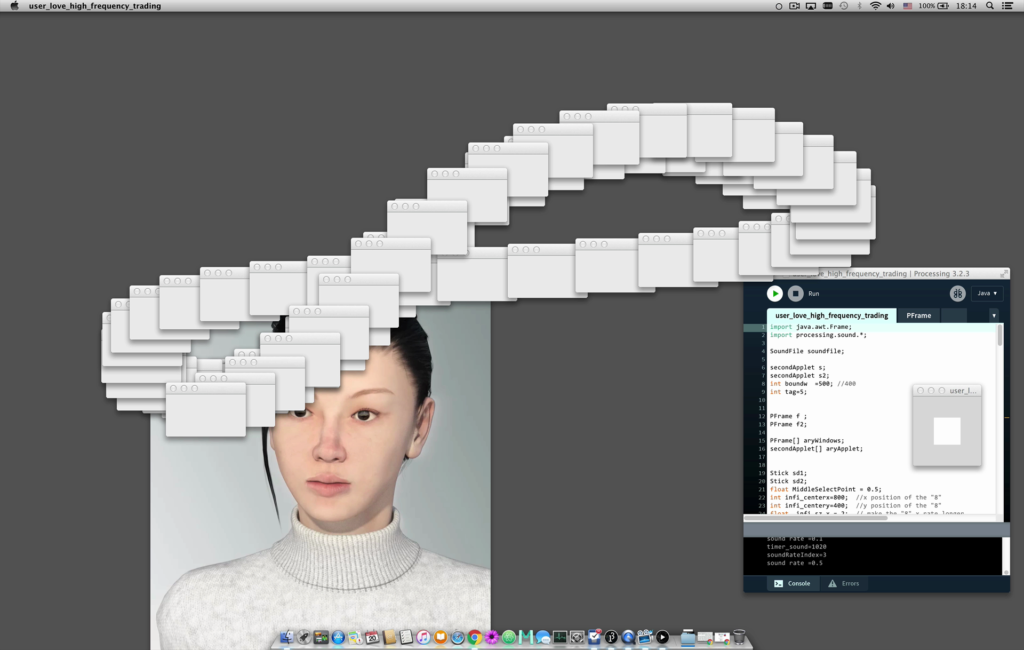

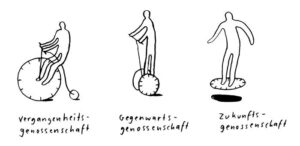

Con intento descrittivo più che speculativo, si può dunque affermare che, quando si parla di Intelligenza Artificiale, ci si riferisce a una particolare categoria di computazione evolutiva; si tratta cioè di algoritmi che operano per lo più in spazio-temporalità digitali e che attuano autonomamente logiche interne di induzione statistica (descrittiva/predittiva) attraverso l’analisi di una contingente rappresentazione del mondo (i dati-input correnti). Un tipico esempio di questa tipologia di agenti intelligenti sono gli algoritmi utilizzati per la compravendita automatizzata di titoli azionari, esemplificativi di una tendenza a delegare l’intervento umano in quei micro-domini temporali in cui è richiesta una velocità di calcolo e decisionale che eccede la scala umana.1616Cf. Virilio (1994).

È bene rilevare che, nonostante si possa parlare di agenti dotati di autonomia cognitiva (e decisionale), l’intervento umano è ancora fortemente presente in diverse fasi della cognizione e dell’apprendimento algoritmico.1717Cf. Pasquinelli (2017). Per questo motivo si parla di ‘apprendimento supervisionato’.

Single Atom in an Ion Trap, University of Oxford 2017 ©David Nadlinger.

Single Atom in an Ion Trap, University of Oxford 2017 ©David Nadlinger.

Primo, questi agenti operano all’interno di dataset strutturati dall’uomo e dunque all’interno di predefinite categorizzazioni del mondo. Per questo motivo, l’applicazione pratica dell’analisi algoritmica in diversi domini di governo (es. polizia preventiva) è spesso criticata per il rischio di replicare semplificate rappresentazioni del mondo o pregiudizi di tipo razziale e di genere.1818Cf. AI NOW Institute (2017); Caliskan et al. (2017).

Secondo, è solitamente un operatore umano a verificare se l’output prodotto corrisponde o meno all’output desiderato. Nel caso di un algoritmo utilizzato per il riconoscimento facciale, per esempio, nella maggior parte dei casi, è un operatore umano a verificare che l’output prodotto sia effettivamente un volto. In caso contrario, la restituzione di un feedback negativo consentirà comunque all’algoritmo di imparare dall’errore commesso così da produrre output desiderabili in futuro. Da questo secondo punto derivano le principali obiezioni e critiche all’Intelligenza Artificiale, che dunque non sarebbe altro che un sistema induttivo di conoscenza limitato alla contingenza dei dati-input, finalizzato alla mera validazione di certe ipotesi iniziali (umane) e strumentale alle logiche di codificazione e redirezione affettiva del tecno-capitalismo cognitivo. Tuttavia, l’aspetto ‘metafisico’ della cognizione algoritmica è riconducibile proprio alla ciclica dinamica di errore-apprendimento che, benché supervisionata dall’uomo, consente, da un lato, di superare di volta in volta le contingenze materiali delle informazioni processate (una particolare descrizione numerica del mondo in un dato momento) e, dall’altro, di emanciparsi dalla conoscenza inizialmente impartita dall’uomo.1919Cf. Parisi (2017).

In altre parole, i sistemi più avanzati di analisi algoritmica attuano forme di serendipità cognitiva, portando alla luce pattern e correlazioni altrimenti imprevedibili all’uomo e consentendo dunque la generazione – e non la mera validazione – di ipotesi.

Un approccio critico e al contempo costruttivo alla cognizione automatizzata dovrebbe dunque, da un lato, preoccuparsi del rischio di reiterare modelli del mondo distorti dal pregiudizio umano e, dall’altro, cercare di capire, confrontarsi e familiarizzare con forme inumane di intelligenza che vanno via via evolvendosi. Ponendosi in questa prospettiva, è forse possibile prevedere uno scenario futuro in cui intelligenza umana e macchinica si contaminano e aumentano a vicenda, diventando l’una prostetica dell’altra, e viceversa.2020A tal proposito, Pasquinelli (2015) suggerisce l’utilizzo dell’espressione ‘Augmented Intelligence’ anziché quella di ‘Artificial Intelligence’.

Si tratterebbe dunque dell’incontro tra due tipologie di intelligenza che avviene, ancor prima che attraverso un riconoscimento formale o normativo (es. la cittadinanza concessa a robot umanoidi), attraverso un’effettiva interdipendenza tecnica e funzionale.

Il vero confronto con forme sempre più sofisticate di Intelligenza Artificiale non andrebbe perciò immaginato all’interno di un parlamento presidiato da androidi che rivendicano il loro diritto al voto e inscritto dunque in una geometria discorsiva del tipo uomini vs. robot. Semmai, si compierebbe attraverso una sintesi materiale e semantica tra sistemi cognitivi diversi che possono esistere in domini spazio-temporali multipli, infinitamente più piccoli – o infinitamente più grandi – rispetto alla scala umana. Questa sintesi non è da intendersi in chiave escatologica, come il compimento dell’umano nell’ultra-umano di una singolarità tecnologica, ma come il graduale passaggio verso un’economia cognitiva post-antropocentrica in cui la generazione di conoscenza è multi-locata e in cui la contaminazione tra umano e inumano prende forma lungo traiettorie imprevedibili, se non aliene.

More on Magazine & Editions

Magazine , CAOS – Part I

Algoritmi psichedelici

Abbiamo provato Ai Lai, l’intelligenza artificiale con cui l’artista Roberto Fassone indaga i meccanismi della creatività e della coscienza combinando l’imprevisto del machine learning con i trip report delle esperienze psichedeliche.

Magazine , ANATOMIA – Part II

Le biotecnologie come nuovo strumento di liberazione e di invenzione di sé stessi

Analisi del complesso rapporto tra bioetica e biotecnologie: la prefazione di “Hypernature. Tecnoetica e tecnoutopie dal presente”, volume edito da KABUL Editions.

Editions

Estrogeni Open Source

Dalle biomolecole alla biopolitica… Il biopotere istituzionalizzato degli ormoni!

Editions

Hypernature. Tecnoetica e tecnoutopie dal presente

Dinosauri riportati in vita, nanorobot in grado di ripristinare interi ecosistemi, esseri umani geneticamente potenziati. Ma anche intelligenze artificiali ispirate alle piante, sofisticati sistemi...

More on Digital Library & Projects

Digital Library

È pensato per fare schifo: l’estetica dell’“Internet Ugly”

Nick Douglas analizza il codice memetico di Internet tra viralità, appropriazionismo e tendenze revivalistiche.

Digital Library

Fine della manodopera: come proteggere i lavoratori dall'ascesa dei robot

Robot ed economia: il punto di vista di Noah Smith sulla diffusione della manodopera robot.

Projects

KABUL ft. Contemporary Cluster

Un'intervista alla redazione di KABUL sulla pubblicazione di "Hypernature. Tecnoetica e tecnoutopie dal presente".

Projects

Antropologia del mondo virtuale: Jon Rafman in conversazione con Diana Baldon

La registrazione della conversazione tra l’artista Jon Rafman e Diana Baldon, direttrice di Fondazione Modena Arti Visive, in occasione della personale realizzata da Fondazione Modena Arti Visive.

Iscriviti alla Newsletter

"Information is power. But like all power, there are those who want to keep it for themselves. But sharing isn’t immoral – it’s a moral imperative” (Aaron Swartz)

-

Fabio Iapaolo è dottorando in Urban and Regional Development al Politecnico di Torino e visiting member del gruppo di ricerca Artificial Intelligence and Mediatheory (KIM), HfG-Karlsruhe. Il suo lavoro verte sulle implicazioni spaziali e culturali dell'Intelligenza Artificiale. È cofondatore del collettivo artistico multimediale Realia.

AI Now Institute, AI Now 2017 Report, 2017, versione pdf: https://ainowinstitute.org/AI_Now_2017_Report.pdf

B. H. Bratton, Outing Artificial Intelligence: Reckoning with Turing Tests, in M. Pasquinelli (a cura di), Alleys of Your Mind: Augmented Intelligence and Its Traumas, Meson Press, Lüneburg 2015. pp. 69–79.

A. Caliskan, J. J. Bryson, A. Narayanan, Semantics derived automatically from language corpora contain human-like biases, «Science», 356, 6334, 2017, pp. 183-186.

N. K. Hayles, Cognition Everywhere: The Rise of the Cognitive Nonconscious and the Costs of Consciousness, «New Literary History», 45, 2, 2014, pp. 199-220.

J. McCarthy, M. L. Minsky, N. Rochester, C. E. Shannon, Proposal for the Dartmouth summer research project on artificial intelligence, Tech. rep., Dartmouth College, 1955.

L. Parisi, Contagious Architecture: Computation, Aesthetics, and Space, MIT Press, Cambridge and London 2013.

M. Pasquinelli (a cura di), Alleys of Your Mind: Augmented Intelligence and Its Traumas, Meson Press, Lüneburg 2015.

S. Russell, P. Norvig (a cura di), Artificial Intelligence: A Modern Approach, Prentice Hall, Upper Saddle River 2009 (3° ed.).

P. Virilio, The Vision Machine, Indiana University Press, Bloomington 1994.

A. M. Turing, Computing Machinery and Intelligence, «Mind», 59, 236, pp. 433-460, 1950.

SITOGRAFIA

B. H. Bratton, Some Trace Effects of the Post-Anthropocene: On Accelerationist Geopolitical Aesthetics, «e-flux», 46, June 2013.

L. Parisi, Reprogramming Decisionism, «e-flux», 85, Oct. 2017.

M. Pasquinelli, Machines that Morph Logic: Neural Networks and the Distorted Automation of Intelligence as Statistical Inference, «Glass-Blead», 1, 2017.

KABUL è una rivista di arti e culture contemporanee (KABUL magazine), una casa editrice indipendente (KABUL editions), un archivio digitale gratuito di traduzioni (KABUL digital library), un’associazione culturale no profit (KABUL projects). KABUL opera dal 2016 per la promozione della cultura contemporanea in Italia. Insieme a critici, docenti universitari e operatori del settore, si occupa di divulgare argomenti e ricerche centrali nell’attuale dibattito artistico e culturale internazionale.